ARTICLE – AI Act : décryptage de la nouvelle réglementation européenne sur l’intelligence artificielle

Publié le 12/12/2024 ACTU JURIDIQUE. Assouan Bougherara senior manager chez Smart Global Governance

Dans un contexte de révolution technologique, l’intelligence artificielle (IA) se présente comme le catalyseur d’innovations sans précédent, entraînant une transformation profonde de nos sociétés et de nos économies. Cependant, face à cette progression fulgurante, une question essentielle se pose : comment réguler l’IA afin qu’elle puisse être utile à l’humanité sans compromettre nos valeurs fondamentales ? Le projet ambitieux de l’AI Act, une réglementation visant à concilier l’innovation et la protection des droits des citoyens, est une réponse de l’Europe à ce défi aussi passionnant qu’immense.

L’intelligence artificielle (IA) est au cœur des préoccupations législatives tant en France qu’en Europe, ainsi qu’à l’échelle internationale. Les réglementations existantes ou en préparation couvrent divers aspects de son utilisation, incluant la protection des données, la sécurité et l’éthique.

Le cadre européen : le projet d’AI Act

Au niveau européen, le projet d’AI Actest une régulation clé en cours d’élaboration. Cette proposition législative vise à encadrer l’utilisation de l’IA au sein de l’Union européenne en établissant des règles strictes pour protéger les droits des citoyens tout en favorisant l’innovation. L’AI Actrepose sur trois principes fondamentaux :

• la protection des droits fondamentaux : en cohérence avec le RGPD, l’AI Actentend garantir que l’IA respecte les droits et les valeurs fondamentales de l’Union européenne ;

• la promotion de l’innovation : l’objectif est de soutenir le développement de technologies d’IA tout en assurant un usage éthique et sécurisé ;

• l’harmonisation juridique : il s’agit de créer un cadre réglementaire cohérent à l’échelle européenne, appliqué uniformément dans tous les États membres.

Champ d’application de l’AI Act

Le projet d’AI Actconcerne un large éventail d’acteurs impliqués dans le cycle de vie des systèmes d’IA, dès lors que leurs services sont distribués ou utilisés au sein de l’Union européenne. Trois catégories principales sont identifiées :

• les fournisseurs : créateurs ou développeurs de systèmes d’IA, responsables de la conformité technique de leurs produits avec les exigences réglementaires ;

• les distributeurs : entités qui commercialisent ou fournissent des solutions d’IA à d’autres organisations, tenues de vérifier que les systèmes respectent les normes en vigueur ;

• les utilisateurs : organisations qui intègrent directement des systèmes d’IA dans leurs processus internes, comme l’automatisation des tâches RH, le tri de CV ou la gestion de la relation client.

Ainsi, que l’on soit développeur, intégrateur ou utilisateur, l’AI Actimpose des obligations spécifiques pour assurer une utilisation responsable et conforme des technologies d’IA.

Classification des risques

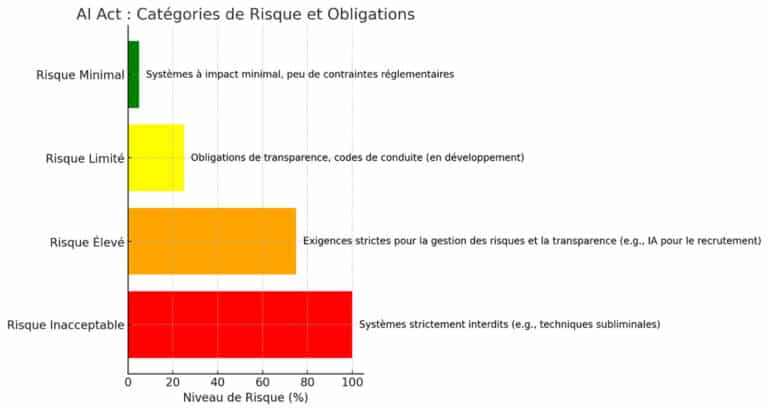

Un des éléments centraux de l’AI Actest la catégorisation des systèmes d’IA selon quatre niveaux de risque, déterminant les contraintes et obligations applicables :

• le risque inacceptable : ces systèmes sont strictement interdits. Ils incluent les IA utilisant des techniques subliminales pour manipuler les comportements humains, altérer le jugement ou causer des préjudices importants ;

• le risque élevé : ces systèmes ne sont pas prohibés, mais doivent respecter des exigences strictes en matière de gestion des risques, de transparence et d’évaluation. Par exemple, les IA utilisées dans les processus de recrutement automatisé doivent fournir des garanties sur les méthodes de sélection et les critères d’évaluation, avec une intervention humaine appropriée ;

• le risque limité : ces systèmes sont soumis à des obligations de transparence, et leur utilisation repose sur des codes de conduite encore en cours d’élaboration ;

• le risque minimal : ces systèmes présentent un impact négligeable et sont soumis à peu de contraintes réglementaires.

Les huit catégories du risque inacceptable

Le risque inacceptable est subdivisé en huit catégories spécifiques :

• une IA manipulatrice : systèmes recourant à des techniques subliminales pour influencer les individus ;

• l’exploitation des vulnérabilités : IA exploitant les faiblesses de certaines personnes pour altérer leur comportement ;

• le profilage social : systèmes de notation sociale, similaires au crédit social en Chine ;

• la prédiction des infractions pénales : IA utilisant le profilage pour prédire des comportements criminels, comme le système COMPAS aux États-Unis ;

• l’extraction massive de données biométriques : IA collectant des images faciales pour constituer des bases de données de reconnaissance faciale sans consentement ;

• la reconnaissance des émotions au travail :systèmes analysant les émotions des employés, pouvant porter atteinte à leur vie privée ;

• le profilage biométrique hors domaine répressif : utilisation de données biométriques à des fins de profilage en dehors du cadre légal strict ;

• la surveillance biométrique en temps réel : IA effectuant un profilage et une identification biométrique instantanés dans le domaine répressif sans cadre légal adéquat.

Les IA génératives et à fort impact

Les IA génératives, telles que ChatGPT, occupent une place particulière en raison de leur potentiel d’influence à grande échelle et de leur impact systémique. L’AI Actimpose des obligations spécifiques pour ces IA à fort impact, incluant la production de documentations techniques détaillées, des tests contradictoires pour vérifier leur fonctionnement et des mesures visant à atténuer les risques systémiques qu’elles pourraient engendrer.

Implications pour les entreprises

Pour les entreprises, la mise en conformité avec l’AI Actconstituera un enjeu crucial. Les systèmes d’IA à haut risque, utilisés notamment dans les processus RH (tri de CV, entretiens vidéo automatisés, tests prédictifs), seront particulièrement concernés. Ces systèmes devront satisfaire à des critères stricts de transparence, de gestion des biais et de documentation des processus utilisés.

Les entreprises devront également mettre en place des évaluations régulières des risques associés à l’utilisation de l’IA et prévoir des mesures correctives en cas de détection de biais ou de problèmes. De plus, l’obtention d’un certificat de conformité sera nécessaire pour continuer à utiliser légalement ces systèmes.

Un avenir réglementaire en construction

Les réglementations relatives à l’IA continueront d’évoluer dans les mois et années à venir. Il est impératif pour les entreprises de rester vigilantes quant à ces évolutions législatives et de veiller au respect des nouvelles obligations imposées tant par l’Union européenne que par les régulations internationales. Si certaines dispositions sont déjà en place, d’autres, comme les codes de conduite ou les analyses d’impact plus détaillées, sont encore en cours d’élaboration.